1.研究背景与行业趋势

1.1数据中心散热挑战

随着AI、HPC(高性能计算)和5G的快速发展,数据中心功率密度急剧上升,传统风冷技术已无法满足高算力芯片(如GPU、ASIC、光芯片)的散热需求。据IDC预测,到2027年,全球液冷数据中心市场规模将突破200亿美元,年复合增长率(CAGR)达25%。

1.2液冷技术成为主流

- 浸没式液冷:直接接触冷却,PUE可低至1.02-1.05,适用于超高密度算力集群。

- 冷板式液冷:适用于部分液冷改造场景,但散热效率低于浸没式。

- 硅光技术+液冷:硅光子(SiPh)可降低光模块功耗,结合液冷可进一步提升能效比。

易飞扬作为光互连技术领导者,率先布局浸没液冷延长器和硅光液冷光模块,推动数据中心向低碳、高密度方向发展。

2.技术研究分析

2.1浸没液冷延长器

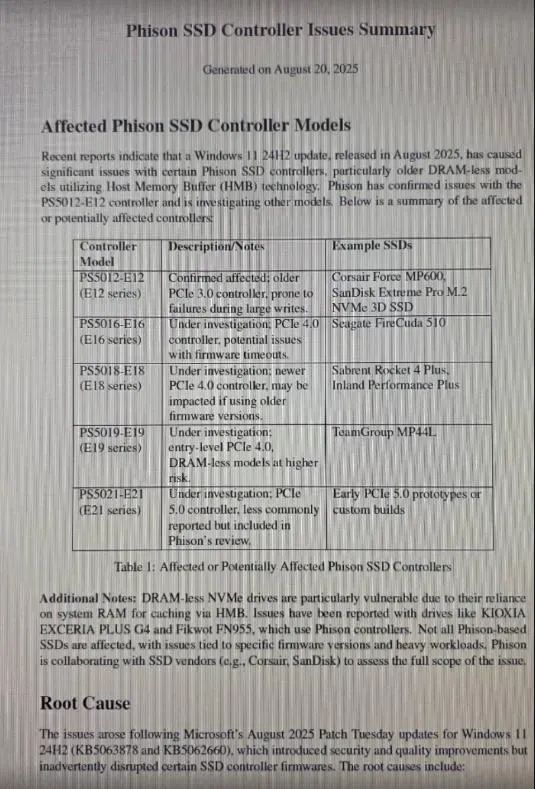

技术特点

产品设计:采用高速线芯,支持最大延长距离7米,产品延续了我司鱼型专利外观设计,

兼容主流光模块:支持QSFP28、QSFP-DD、OSFP、SFP112等多种封装类型,适配25G~800G及未来1.6T光模块,灵活满足不同场景需求

散热管理优化:连接插座上配有1.5W静音风扇,具有较强的散热能力

可视化监控指示灯:适用于交换机端口频繁插拔使用场合,可有效延长端口寿命。

易飞扬液冷延长器系列

| 序号 |

名称 |

封装 |

状态 |

规格 |

| 1 |

100G |

QSFP28 |

MP(批量) |

26AWG,最长0.5m |

| 2 |

200G |

QSFP28 |

MP(批量) |

26AWG,最长0.5m |

| 3 |

400G |

QSFP-DD |

MP(批量) |

26AWG,最长0.5m |

| 4 |

800G |

QSFP-DD |

优化 |

30AWG,0.3m |

| 5 |

25G/56G |

SFP28/56 |

设计 |

|

| 6 |

112G |

SFP112 |

设计 |

|

| 7 |

800G |

OSFP |

设计 |

|

| 8 |

400G |

OSFP-RHS |

设计 |

|

| 9 |

800G |

OSFP to QDD extender |

设计 |

|

2.2硅光液冷光模块

技术特点

- 硅光集成(SiPh):高集成、低功耗、低成本和高速传输,降低光模块功耗30%,支持400G/800G及1.6T高速传输。

- 封装设计:独特的外壳气密封装设计,耐压大于0.2Mpa,壳体使用高导散热热材料,液冷环境下散热效率提升50%。壳体设计有密封性检测阀,确保密封质量;

- 兼容性:支持QSFP112、QSFP-DD、OSFP、OSFP RHS等多种封装类型,适配100G~800G及未来1.6T光模块;

- CPO(共封装光学)兼容:为未来51.2T交换机提供超低功耗方案。

- 液冷液体类型:氟化液、矿物油和硅油等

易飞扬硅光液冷光模块系列

| 序号 |

名称 |

封装 |

状态 |

备注 |

| 1 |

400G DR4 |

QSFP112 |

样品 |

Inphi DSP + 硅光方案 |

| 2 |

400G DR4 |

OSFP RHS |

样品 |

Inphi DSP + 硅光方案 |

| 3 |

800G DR8 |

OSFP |

样品 |

Inphi DSP + 硅光方案 |

3.市场应用与竞争优势

3.1目标市场

- 超算中心:需超高密度液冷方案,如GPU/CPU集群。

- 云计算巨头:Google、AWS、阿里云等推进液冷数据中心建设。

- 边缘计算:高功率边缘服务器需紧凑型液冷光互连。

3.2竞争优势

- 全栈液冷光互连方案:从光模块到液冷延长器,提供端到端支持。

- 硅光+液冷双重降耗:相比传统方案,整体能效提升40%。

- 开放生态合作:与芯片厂商、液冷系统供应商联合优化方案。

4.未来展望

- 1.6T液冷光模块:预计2026年进入商用,支持下一代AI集群。

- CPO大规模部署:液冷将成为CPO技术的必备散热方案。

- 标准化进程:推动行业制定液冷光互连技术标准,加速普及。

5.结论

易飞扬的浸没液冷延长器和硅光液冷光模块代表了数据中心光互连技术的未来方向,不仅解决高算力散热难题,更推动全球数据中心向低碳化、高密度化迈进。随着AI算力需求爆发,液冷光互连市场将迎来高速增长,易飞扬有望成为行业核心供应商。